- A5M2 のダウンロード

- Wine のインストール(Homebrewで)

brew install --cask --no-quarantine gcenx/wine/wine-crossover - Wine のライブラリのインストール

brew install winetricks

winetricks fakejapanese_ipamona

注:Winetricks が Wine のライブラリを管理するツールで、fakejapanese_ipamona がMSゴシック等の代替フォントとのことです。 - インストールが完了したら、A5M2 を起動します。

-

A5M2(A5:SQL Mk-2)を macOS で起動させてみる技術ブログに投稿されました

-

#M2 Max after 13.3.1Flutterに投稿されました

返信: Flutter install on MacOS M2

#M2 Max after 13.3.1

#COCOPODS GEM ruby

#以下のコマンドはエラーになる。cocoapods 2.7.6以上のRUBYが必要です。13.3.1時は2.6.Xになっているため、Rubyのバージョンアップが必要です。

sudo gem install cocoapods#ruby

brew install rbenv ruby-buildrbenv -v

echo $SHELL

#zsh

echo 'eval "$(rbenv init -)"' >> ~/.zshrc

source ~/.zshrcrbenv install --list

rbenv install 3.0.6

rbenv versions -

フォルダの中のファイルに日本語を抽出するPythonに投稿されました

# This is a sample Python script. import os import re # 対象パス<---input please dir_path: str = "/Users/aoyamanozomu/PycharmProjects/test" def findAll(dir_path: object) -> object: for root, dirs, files in os.walk(dir_path): print('directory:', root) for subdir in dirs: print('sub directory:', os.path.join(root, subdir)) for file in files: print('file :', os.path.join(root, file)) print_japanese(file) def print_japanese(filename): print(f'File: {filename}') with open(dir_path + '/' + filename, 'r') as f: content = f.read() # find japanese pattern = re.compile(r'[\u3000-\u303F\u3040-\u309F\u30A0-\u30FF\u4E00-\u9FFF]+') matches = re.findall(pattern, content) for match in matches: print(match) # Press the green button in the gutter to run the script. if __name__ == '__main__': findAll(dir_path) -

New deadline: Target API Level共通ディスカッションに投稿されました

Hello Google Play Developer,

Last year, we announced that we’re expanding our target API level requirements to protect users from installing apps that may not have the latest privacy and security features.

To help make Target API level deadlines clearer, we are unifying the dates to August 31 every year.

Starting August 31, 2023:

New apps and app updates must target API level 33 to be submitted to Google Play (Wear OS must target API 30).

Existing apps must target API level 31 or above to remain discoverable by all users on Google Play. Apps that target API level 30 or below (target API level 29 or below for Wear OS), will only be discoverable on devices running Android OS same or lower than your apps’ target API level.

You will be able to request an extension to November 1, 2023 if you need more time to update your app. You'll be able to access your app's extension forms in Play Console later this year.

We want to make sure you have ample time and resources to get prepared:

For exact timelines, read Target API level requirements for Google Play apps

For technical guidance, refer to this migration guide

To learn more, watch the April 2022 PolicyBytes

Thank you for continuing to partner with us to make Google Play a trustworthy platform for you and your users. -

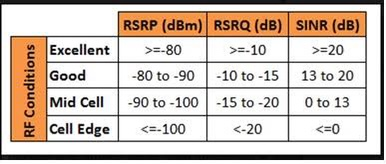

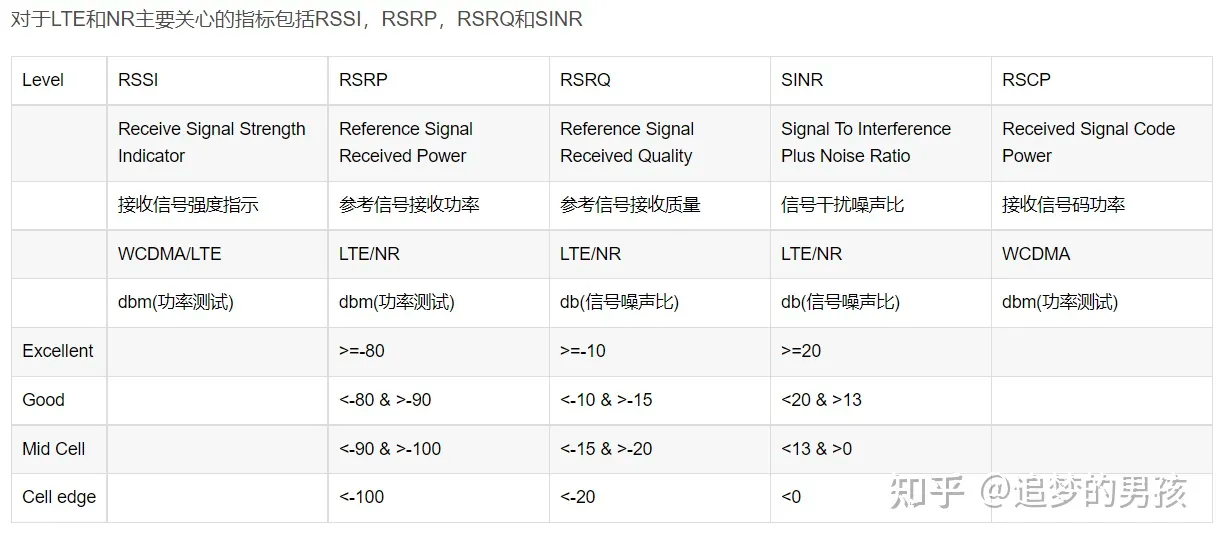

中国語:RSRP、RSRQ、SINR説明通信RFに投稿されました

返信: アンテナ指標

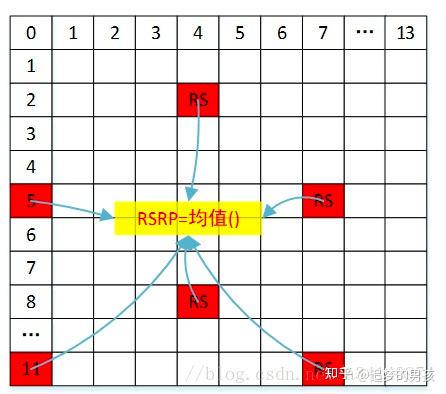

1,RSRP

RSRP,Reference Singal Receiving Power,是指定测量频带上,承载小区专属参考信号的资源粒子的功率贡献(单位w)的线性平均值(协议规定RSRP指的是每RE的能量,但每个RE中都安插RS不可实现因此,只能算在RB中安插几个之后算均值),如下图所示。简单的可以认为RSRP就是每个subcarrier的功率。

2,RSSI

RSSI,Reference Singal Strength Indicator,指的是接收带宽内的总功率,包括有用信号、干扰和底噪。测量的参考点位UE的天线端口。

3,RSRQ

RSRQ,Reference Signal Receiving Quality,定义为

RSRQ=N∗RSRP/(E−UTRAcarrierRSSI)

RSRQ=N∗RSRP/(E−UTRAcarrierRSSI)

其中N为E-UTRA carrier RSSI测量带宽中的RB数量。协议规定RSRQ相对于每RB进行测量的,这与RSRP相对于RE的规定是不同的。从公式可以推断出RSRQ的对数一般为负值。

3,SINR

SINR, Signal to Interference plus Noise Ratio,指的是信号与干扰加噪声比(SINR)是接收到的有用信号的强度与接收到的干扰信号(噪声和干扰)的强度的比值;可以简单的理解为“信噪比”。

-

KeycloakInfraに投稿されました

Keycloak(キークローク)とは、Web上でのシングルサインオン(SSO)(※1)を実現するためのJavaベースの認証ソフトウェアで、2014年にバージョン1.0.0がリリースされた、競合他社製品に比較すると後発のものとなります。Keycloakは、Red Hat JBossプロジェクトが開発を進めているOSS(オープンソースソフトウェア)であり、Apacheライセンスとしてソースコードが公開されています。Keycloakは、最新のアプリケーションやサービスとの連携を目的としており、機能についても認証だけではなく、各種フェデレーション(SAML、OpenID Connect対応)やセルフサービス等が備わっています。

また、Red Hat社は、公式サブスクリプションの「Red Hat JBoss EAP」に付属する製品として、Keycloakをベースとした「Red Hat SSO」を販売しています。「Red Hat JBoss EAP」および「Red Hat SSO」の保守サポートやマイグレーションについても、弊社までお気軽にお問い合わせください。

※1 シングルサインオン(Single Sign-On:SSO)とは、企業内の複数の情報システムのユーザIDを統合管理し、利用するシステム毎にユーザID/パスワード等の入力による認証を必要とせず、一度だけの認証(一つのユーザIDとパスワード)で複数システムを利用できる仕組みです。シングルサインオンはユーザやシステム管理者の ID管理の手間を軽減するだけでなく、個人情報の漏洩防止やセキュリティ対策、アクセス制御を統合・強化といった観点からも現在多くの企業にとって欠かせないものになっています。Keycloakの業界標準仕様対応

Keycloakは、業界標準の、以下の仕様をサポートしています。-

SAML 2.0

標準化団体OASISによって策定された、IDやパスワードなどの認証情報を安全に交換するためのXML仕様です。歴史あるプロトコルのため、多くのアイデンティティ管理ベンダーによって実装されており、提供されているサービスやソフトウェアが多く、Google AppsやSalesforceなどのクラウドサービス、学認(Shibboleth)などとの連携が可能です。 -

OpenID Connect

標準化団体OpenID Foundationによって策定されたREST/JSONベースのプロトコルです。OAuth 2.0をベースに認証目的でも利用できるように拡張しています。野村総合研究所、グーグルなどにより開発が開始され、2014年2月に最終承認された現在最も新しいフェデレーションプロトコルです。多くの企業がサポートを表明しており、今後普及していく可能性が高く、グーグル、マイクロソフト、セールスフォースなどが既に一部のサービスでサポートを開始し、国内でもヤフー、ミクシィなどのサービスで実装されています。 -

OAuth 2.0

OAuth 2.0は仕様が簡略化され使いやすくなった次世代のOAuthプロトコルであり、クライアントとなるWebアプリ、デスクトップアプリ、スマートフォン、リビングデバイス等のクライアントプロファイルを仕様化しています。認証ではなく、認可(どのリソースにアクセスできるか)について規定している点で他のプロトコルとは異なります。Facebook、Google Apps、Windows Liveなどさまざまなサービスで実装されています。

-

-

Apache KafkaInfraに投稿されました

Apache Kafkaの概要

Apache Kafka(アパッチ カフカ)は、JavaとScalaで書かれたオープンソースの分散ストーリーミング送受信処理基盤であり、メッセージキュー(MQ)やメッセージングシステムと似通ったソフトウェアです。ストリームデータとは、サーバのログ、ユーザの購入履歴やSNSの投稿など、様々なデータの集合のことです。

KafkaはアメリカのビジネスSNS企業であるLinkedInで2011年頃に開発されオープンソース化されました。その後、Apacheソフトウェア財団のプロジェクトとして認められ、現在はApacheソフトウェア財団の管理下で開発が継続されています。また、LinkedInでKafkaの開発に関わった主要メンバー達はConfluentという会社を立ち上げKafkaのEnterprise向けサービスを行っています。Apache Kafkaの主な特徴

Kafkaは、複数のアプリケーションやデータベース間でストリームデータの中継点として送受信をする役目を担います。耐障害のために、送信側(Producer)からのストリームデータを保存するフォールトトレラントな設計となっています。各Producerから送られてくるストリームデータはTopicと呼ばれ、Topic毎にカテゴライズされて保存されます。

Topicの中身はrecordと呼ばれるkey-valueで構成されたデータがtimestampをもって順序立てて連続しています。受信側はConsumerと呼ばれ、KafkaはConsumer毎に決められたTopicを送信します。Kafkaは単一構成でも稼働しますが、複数のKafkaサーバを遠隔地のデータセンターに配置してクラスターを構成することも可能です。Kafkaには5つのコアAPIが存在します。

・Producer API

送信側のアプリケーションやDBから1つ以上のopicとしてのストリームデータの配信を許可します。・Consumer API

受信側に1つ以上のTopicとしてのストリームデータの受信と処理を許可します。・Steams API

アプリケーションにストリームプロセッサーとして動作することを許可します。1つ以上のTopicとしてのストリームデータをinputストリームとして受け取り、効果的に変換してoutputストリームとして送信します。・Connector API

既存のアプリケーションやデータベースをProducerやConsumerとして、データをインポートやエクスポートすることを許可します。・Admin API

Topic、broker、およびその他のKafkaオブジェクトを管理および検査できます。Apache Kafkaのユースケース

・Messagingシステム

Kafkaをメッセージブローカーとして利用します。Kafkaはこれまでのメッセージブローカーの代替として十分に機能します。Kafkaは高いスループット、レプリケーションとフォールトトレランス機能を備えていますので、大規模なメッセージプロセッシングシステムを構成するための良いソリューションと考えられます。この分野では、類似のソフトウェアとしてActiveMQや、RabbitMQが存在します。ActiveMQ

http://activemq.apache.org/RabbitMQ

https://www.rabbitmq.com/・Webサイトのアクティビティトラッキング

Kafkaは元々、Webサイトにおけるユーザのアクティビティを収集するため利用されていました。Webサイトでのユーザのアクティビティは、ページビューや検索、ユーザがサイト上で行なう様々な動作が含まれます。それらをリアルタイムにモニタリングすることや、処理を行い収集したデータをHadoopなどのシステムに送信してユーザ動向の解析を行えます。・メトリックスやログの収集

Kafkaは、各システムから送られてくるシステムのメトリックスをモニタリングするために収集する役目を担います。また、多くのユーザはKafkaをログ収集のために利用しています。この分野では、Flumeなどの類似のソフトウェアが存在します。Flume

https://flume.apache.org/・ストリーム処理

Kafkaを、データプロセッシングのパイプラインとして利用します。Kafkaは送信者からデータを受け取って収集し、受信者に向け変換を行い送信します。この分野では、Apache StormやApache Samzaが類似のソフトウェアとして存在します。Apache Storm

https://storm.apache.org/Apache Samza

https://samza.apache.org/・イベントソーシング

Kafkaは、イベントを中心とした状態の変更が時系列の一連のレコードとして記録されるアプリケーション設計となっています。この設計はCQRSで有用で、イベントハブとして利用されます。・コミットログ

Kafkaは、分散システムの外部コミットログとして機能します。ノード間のデータ複製や障害時のデータ復元のメカニズムとしても機能し、また、トピックという概念を用いて、書き込み/読み出しを並列に行うことで、高速かつフォールトトレランスに優れた通信を実現します。Apache Kafkaの動作環境

Kafkaは、下記に示すUnix系OS上で動作します。Windowsで稼働させるには、まだいくつかの問題が残っているため、現状ではWindowsはサポートされるプラットフォームには含まれていません。・主要なLinuxディストリビューション

・Solaris

・macOS

稼働させるにはJavaが必要になります。Apache Kafkaのライセンス

KafkaはApacheのトップレベルプロジェクトの1つです。ライセンスはApache License 2.0となっており、ユーザはそのソフトウェアの使用や頒布、修正、派生版の頒布をすることに制限を受けません。Apache Kafkaの参考情報

Apache Kafka公式サイト

https://kafka.apache.org/Apache Kafka公式ドキュメント

https://kafka.apache.org/documentation/Apache Kafkaエコシステムとして動作するツール一覧

https://cwiki.apache.org/confluence/display/KAFKA/Ecosystem※該当投稿は以下のURLよる転記しています。

https://openstandia.jp/oss_info/apachekafka/ -

Xcode.appのキャッシュ削除技術ブログに投稿されました

Xcode.appのキャッシュ削除

rm -rf ~/Library/Caches/com.apple.dt.Xcode/

Tip: Xcodeがフリーズする場合などに解決策として使われるコマンドのようです。クリーンビルド

xcodebuild clean

xcodebuild -alltargets clean

xcodebuildのヘルプには以下のように記載されています。

Remove build products and intermediate files from the build root (SYMROOT).DerivedData(中間生成ファイル)の削除

後述するDerivedDataディレクトリ配下を削除します。

rm -rf ~/Library/Developer/Xcode/DerivedData/

Tip: 個人的に開発中にもっとも使うことの多いコマンドです。 ~/.bashrcファイルにエイリアスを定義してcleanだけで簡単に実行できるようにしています。

~/.bashrc

alias clean='rm -rf ~/Library/Developer/Xcode/DerivedData'Xcode Toolsによるキャッシュ削除

xcrun --kill-cacheもしくは

xcrun -k

xcrunのドキュメントには以下のように記載されています。

Removes the cache. Causes all values to be re-cached.simctlによるシミュレータの設定削除

シミュレータにインストールしたアプリ、設定を削除

xcrun simctl erase alliOS DeviceSupportのキャッシュ削除

rm -rf ~/Library/Developer/Xcode/iOS\ DeviceSupport/*/Symbols/System/Library/Cachesllvm/clangのキャッシュ削除

rm -rf "$(getconf DARWIN_USER_CACHE_DIR)/org.llvm.clang/ModuleCache"

rm -rf "$(getconf DARWIN_USER_CACHE_DIR)/org.llvm.clang.$(whoami)/ModuleCache"

Tip: getconf DARWIN_USER_CACHE_DIRコマンドにより、/var配下の動的なキャッシュ領域の場所を出力しています。

出力例

$ getconf DARWIN_USER_CACHE_DIR

/var/folders/62/nrp34pc96t560_hhml86hmwrr_q2rc/C/その他OSSライブラリのキャッシュ削除

Homebrewのキャッシュ削除

rm -rf ~/Library/Caches/Homebrew

brew cleanup -s

rm -rf $(brew --cache)SwiftLintのキャッシュ削除

rm -rf ~/Library/Caches/SwiftLintCocoaPodsのキャッシュ削除

pod cache clean --allCarthageのキャッシュ削除

rm -rf ~/Library/Caches/org.carthage.CarthageKit

rm -rf ~/Library/Caches/carthageFastlaneのキャッシュ削除

spaceshipで利用されるクッキーファイルを削除します。

rm ~/.fastlane/spaceship/**/cookie補足:DerivedDataとは

DerivedDataとはXcodeで生成される中間生成ファイルが保存されるディレクトリの名前です。デフォルトの設定では以下の場所に保存されます。

~/Library/Developer/Xcode/DerivedData/

ビルド時の中間生成ファイルとして以下のようなものが保存されます。- ビルド時に生成されるバイナリファイルやデータファイル

- インデックス情報

- ビルドやテストなどのログ

- ソースコードのシンボル情報

以下の順に削除範囲が広くなっていきます。 - Product > Cleanコマンド (DerivedData内の現在のターゲットのBuildフォルダ配下の全てのファイルを削除)

- Product > Clean Build Folderコマンド (DerivedData内の各ターゲットのBuildフォルダを削除)

- rm -rf ~/Library/Developer/Xcode/DerivedData/ (DerivedDataディレクトリ配下を全て削除)